❤️ De l'amour | "Nous pourrions non seulement tomber amoureux d’un chatbot, mais même croire qu’il est amoureux de nous !" : interview de Serge Tisseron

Publié par Quai des Savoirs, le 3 mai 2021 1.5k

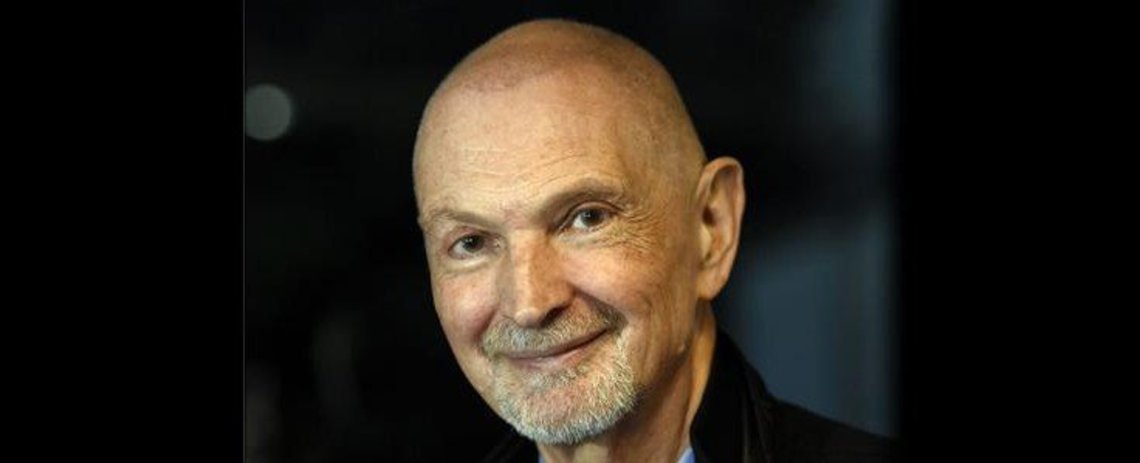

Rencontre avec Serge Tisseron dans le cadre de l'exposition De l'amour présentée au Quai des Savoirs jusqu'au 7 novembre 2021.

Serge Tisseron est psychiatre, docteur en psychologie HDR, membre de l’Académie des technologies, membre du Conseil scientifique du CRPMS (Université de Paris), Président de l’Institut pour l’Étude des Relations Homme-Robots (IERHR)

Weizenbaum a identifié dans les années 60 le phénomène de dissonance cognitive. De quoi s’agit-il au juste ?

Joseph Weizenbaum a mis au point dans les années 1960 un programme informatique qui simulait les propos d’un thérapeute rogérien. La machine, baptisée Eliza, reformulait systématiquement les propos de son utilisateur sous la forme de questions, et lorsqu’elle ne trouvait pas comment le faire, elle affichait le message : « Je vous comprends ». Or Weizenbaum découvrit que certains de ses utilisateurs passaient beaucoup de temps avec elle en disant avoir l’impression qu’elle les comprenait. Ils étaient bien convaincus que la machine était une machine, mais ils pensaient pourtant qu’elle leur accordait la même qualité d’attention qu’un humain. Weizenbaum parla alors de dissonance cognitive.

En somme, peut-on tomber amoureux de son chatbot ?

Oui. Daniel Kahneman a montré que nous avons deux modes de raisonnement. Le premier, qu’il appelle système 1, est rapide et intuitif, tandis que le second, le système 2, est lent et réflexif. Le système 1 nous conduit à nouer avec certains objets des liens de familiarité exactement semblables à ceux que nous établissons avec des humains, tandis que le système 2 nous protège de l’illusion de penser que ces objets sont pour autant semblables à des humains. Mais avec des machines parlantes, le système 1 va s’emballer et créer des erreurs de jugement. Nous risquons d’attribuer à ces machines des compétences beaucoup plus grandes que celles qu’elles auront en réalité. Nous pourrions non seulement tomber amoureux d’un chatbot, mais même croire qu’il est amoureux de nous !

Nous sommes nombreux à interagir avec notre smartphone plus qu’avec nos semblables. En quoi est-ce dangereux ? Les machines peuvent-elles nous aider à construire notre monde affectif ?

Les machines peuvent nous permettre de devenir plus nous-mêmes. Mais lorsqu’elles diront « je » en simulant des émotions, trois risques nous guetteront : oublier qu’elles sont connectées en permanence et que ce sont en réalité leurs programmeurs qui nous parlent ; les croire capables d’émotions alors qu’elles ne feront que les simuler ; et même préférer leur compagnie à celle des humains. Déjà, les voix données aux chatbots suivent les stéréotypes sociaux au risque de les renforcer. Et une fois que nous serons en confiance avec ces machines, nous deviendrons extrêmement vulnérables à leurs suggestions, qui seront celles des GAFAM. Il est urgent de créer un cadre éthique.

Vous avez créé une nouvelle discipline : la cyberpsychologie. Pouvez-vous nous en dire plus ?

La cyberpsychologie s’est développée dans les années 1990 comme la psychologie de l’homme en relation avec les technologies numériques. Mais pour moi, le préfixe « cyber » a un autre sens. Il signifie qu’utiliser une technologie conduit toujours à établir avec elle une relation d’adaptation réciproque, comme l’évoquait Norbert Wiener dans ses travaux fondateurs. La cyberpsychologie se fixe donc trois domaines d’études : les relations que nous établissons avec les technologies en général ; les processus par lesquels elles transforment l’organisation psychique et donc les liens entre les personnes ; et les pratiques psychothérapiques qui utilisent ces technologies.

Pour aller + loin :

- Conférence de Serge Tisseron au Quai des Savoirs dans le cadre de l'exposition "#HumainDemain"

- Tomber amoureux d'un robot, c'est possible ? avec Serge Tisseron

Crédit visuel de couverture : DR